On-policy Control with Approximation

Episodic Semi-gradient Control

这里和上一章的公式的区别只是把状态价值函数改成了动作价值函数,即:

对于一步的Sarsa算法来说,上面的公式应该写为:

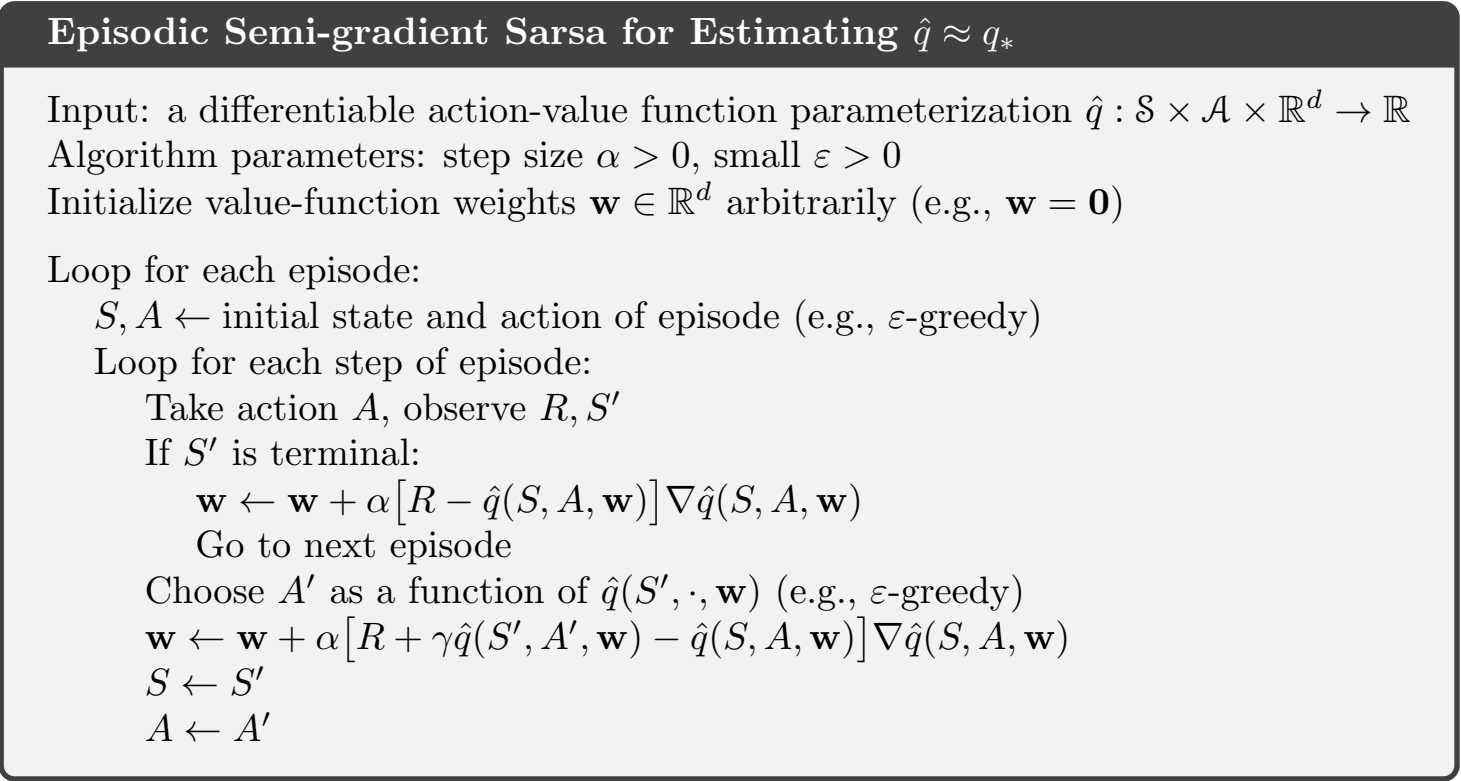

其算法流程图如下:

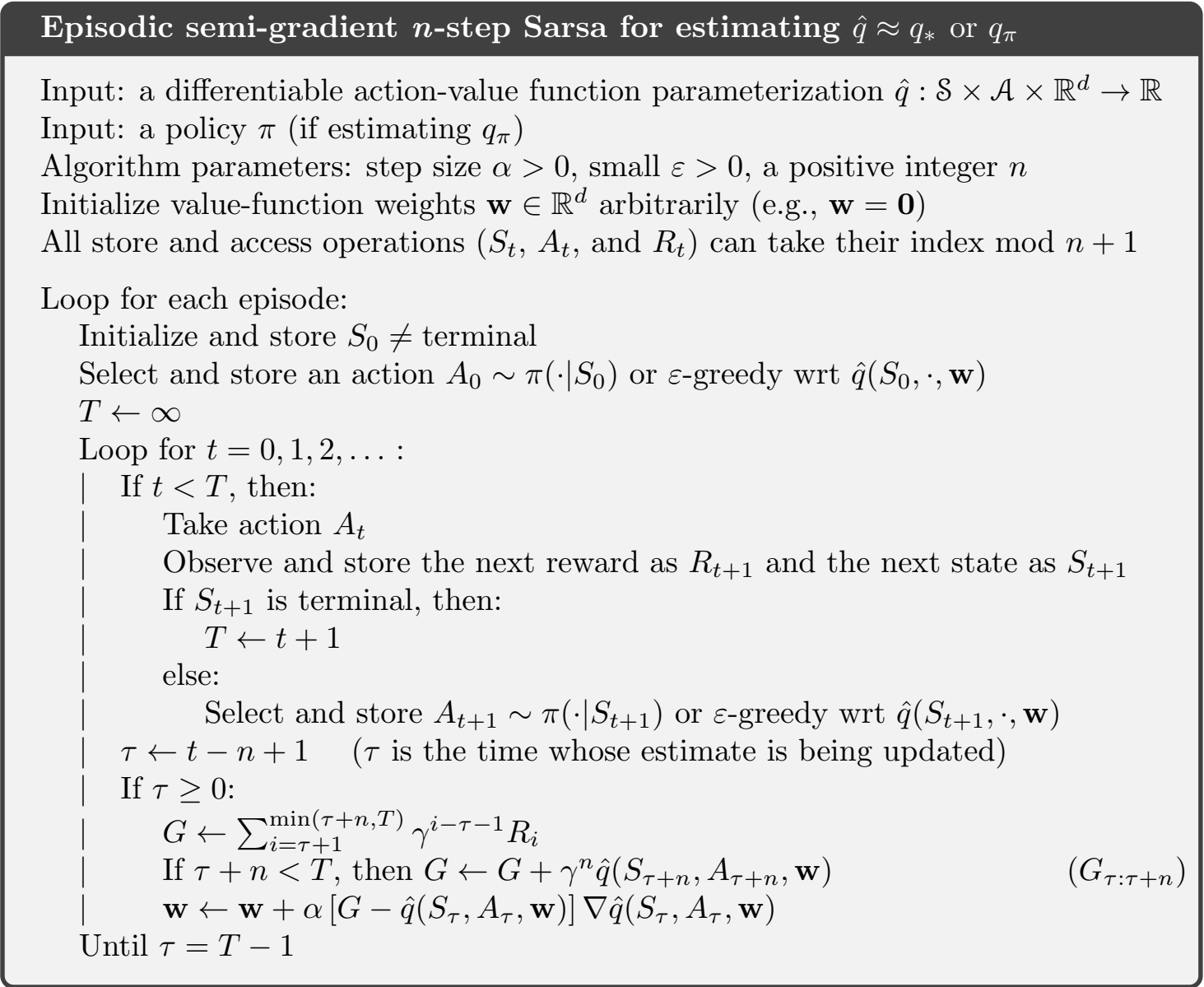

而对于

只是这里的价值函数更新的时候变成了以n为周期的。

平均回报

对于可以分为一个个Episode的任务,前面的折后回报是可以处理的,但是对于连续型任务是不够的,定义一个策略

那么这个时候的状态价值函数、动作价值函数和最优状态价值函数和最优动作价值函数都可以写成一个新的形式:

最优的就是取最大值就行了。

注意到上面的式子里面没有折扣率

了,因为在连续型任务中,先后出现的价值在重要性上没有区别。

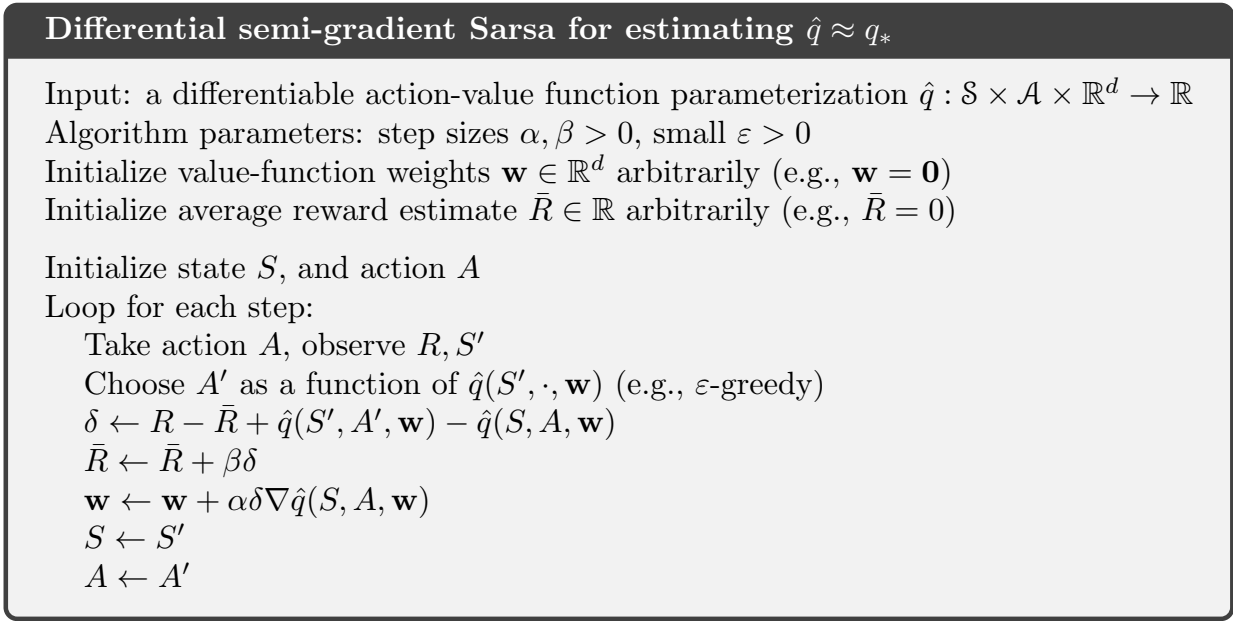

在这种定义下的单步Sarsa算法如下:

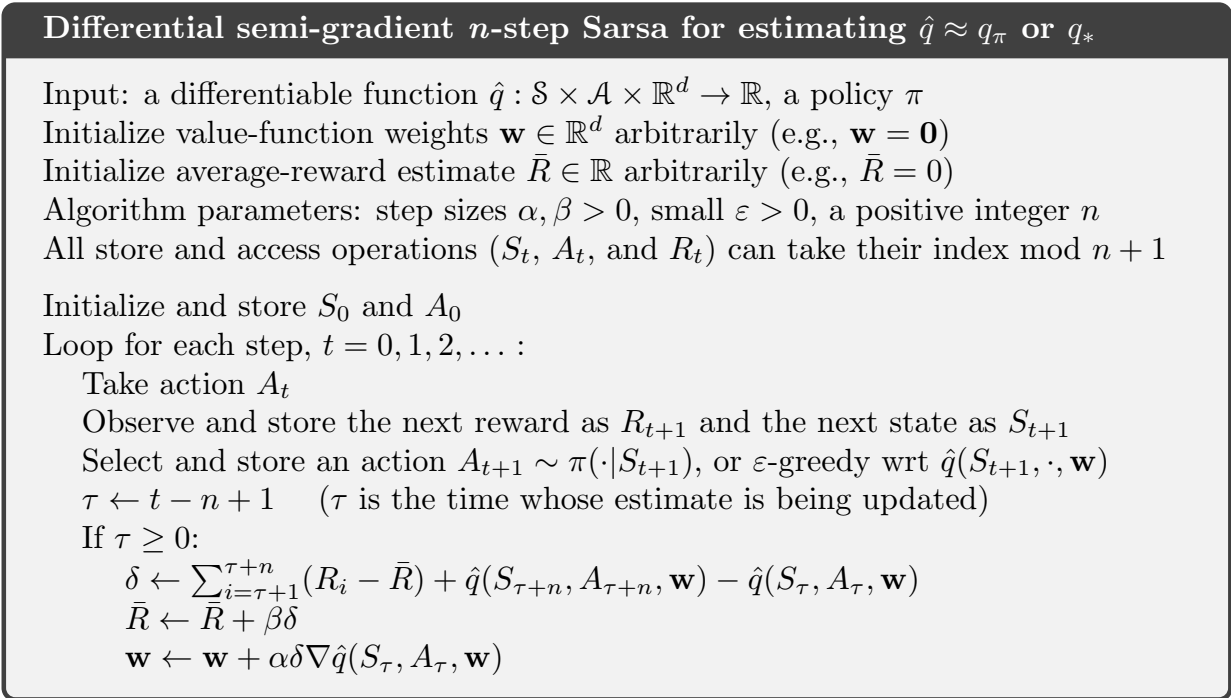

n步Sarsa的算法如下图所示:

All articles on this blog are licensed under CC BY-NC-SA 4.0 unless otherwise stated.