GAIL

最大熵逆强化学习的另一种写法

这里给出IRL的另一种表述形式,即:

这其中的

Hint:中间的

部分可以理解为首先是在确定 的情况下面选择一个策略让 的熵是最大的,然后在这个情况下算出 再真实的专家策略获得的奖励做比较

在学出来这个

关于这个式子怎么推导最佳的策略,请看文章 Maximum Entropy Inverse Reinforcement Learning

GAIL

如果这里的数据量比较小,就会导致过拟合,所以考虑加上一个对于奖励函数

那么这样重建出来的就是及满足了熵正则又不会过拟合

怎么解上面的式子

考虑定义一个occupancy measure

可以认为这个是策略

如果有了这个重建的策略定义为:

经过一通算可以发现,这里最后的优化目标就是找到

而带入 occupancy measure 可以把上面的式子改成

而这恰好是拉格朗日对偶函数

正则化器的定义

首先定义

然后定义正则化器为:

对于给专家数据状态-动作对赋予较⼤负代价的代价函数,该正则化器赋予其⼩的惩罚项,⽽对于给其分配代价接近零,则赋予较⼤的处罚项。

经过推导可以得到:

Hint:注意这里的

不是说离散的0或1而是一个 区间里面的数

新的优化目标

发现这里最优的损失是使用 JS 散度,即目标为:

而

所以最后的目标就是找到表达式:

的一个鞍点。

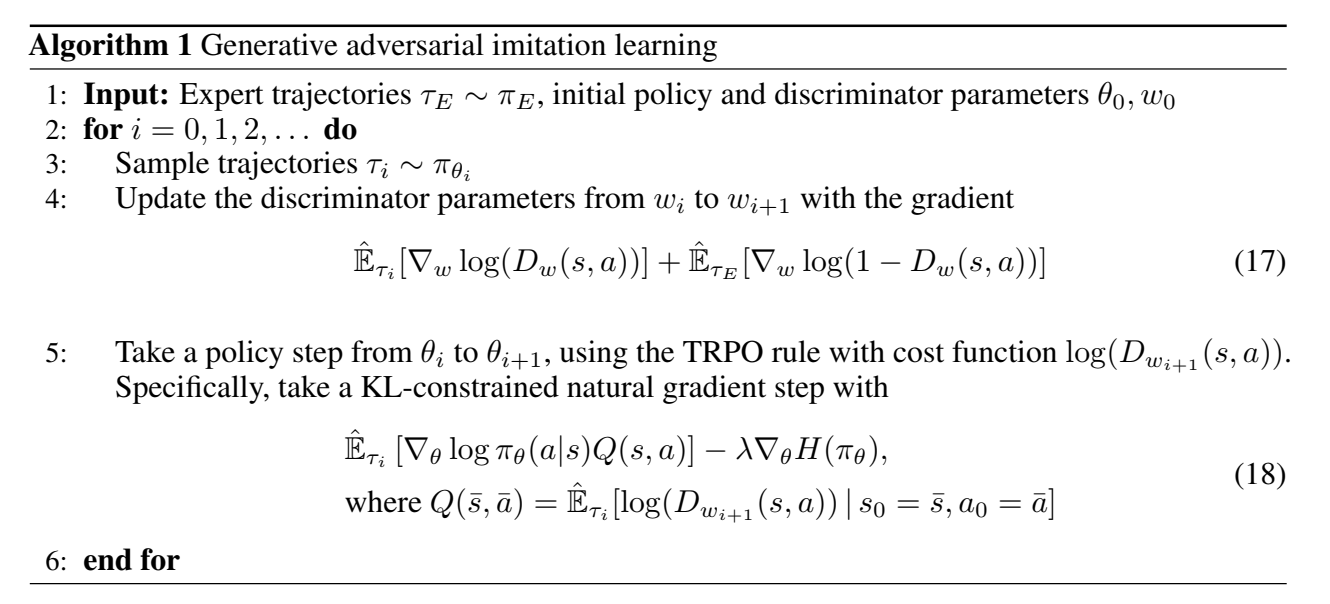

算法

首先生成器会生成一个带有参数